De nombreux employés dévoilent des infos confidentielles sur leur entreprise et leurs missions aux chatbot des IA. Ces discussions sont stockées et peuvent ressortir dans d’autres échanges à l’avenir.

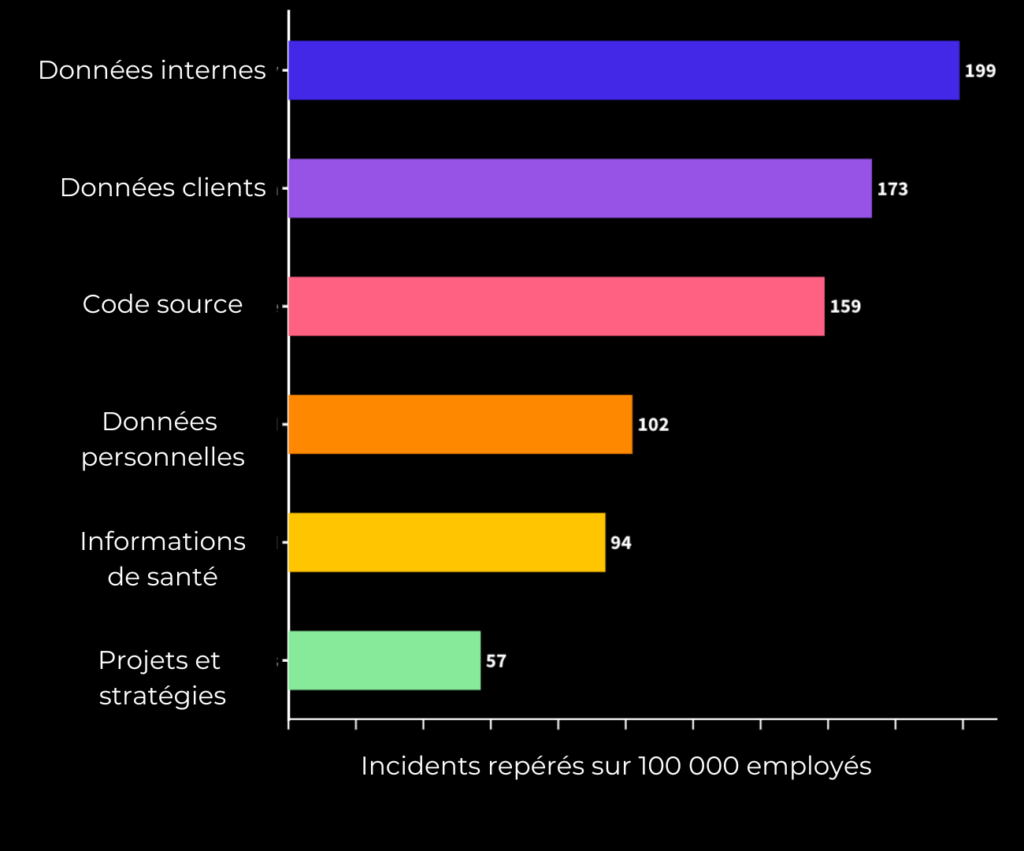

Une IA n’est pas tenue par le secret professionnel. Beaucoup trop de personnes ont accordé leur confiance à ChatGPT, oubliant que cet outil conserve aussi les données. Une étude de la société de cybersécurité Cyberhaven, publiée en février et repérée par DarkReading le 7 mars 2023, révèle que plusieurs dizaines de milliers d’employés ont transmis des données d’entreprises au chatbot de la société OpenAI. Sur 1,6 million de postes surveillées par l’entreprise de cybersécurité, 2,6 % des utilisateurs sont allés jusqu’à dévoiler des infos confidentielles à l’IA.

Ce risque est devenu suffisamment important en l’espace de trois mois, depuis la sortie de ChatGPT, pour que plusieurs multinationales interdisent cet outil dans leurs bureaux, à l’instar de JP Morgan ou Vérizon.

Des discussions internes chez Amazon, divulgués au média américain Insider, révèlent que le service juridique s’est saisi de l’affaire. Un avocat du groupe a déclaré aux employés avoir vu des textes générés par ChatGPT, ressemblant « étroitement » aux données internes de l’entreprise. Les salariés d’Amazon doivent désormais éviter de fournir du contenu au modèle de langage.

Microsoft, investisseur et partenaire d’Open AI – au point d’inclure l’outil dans le moteur de recherche Bing – autorise ses employés à converser avec le chatbot à condition de ne pas partager d’infos sensibles de l’entreprise également.

Des conversations privées recyclées par ChatGPT

Concrètement, quel est le danger ? Un cadre a, par exemple, copié et collé un document stratégique pour 2023 de son groupe, lui demandant de fournir une présentation PowerPoint. Or, par définition, une intelligence artificielle travaille à partir d’une base de données pour s’améliorer. Une discussion censée être professionnellement confidentielle pourrait parfaitement être enregistrée et des formules pourraient ressortir lors d’un échange avec un autre utilisateur.

Pire, une attaque sur les serveurs permettrait de récupérer directement des discussions. Rappelons par ailleurs que ces dernières ne sont pas chiffrées. Dans un article publié en juin 2021, une douzaine de chercheurs issus d’une liste d’entreprises et d’universités (dont Apple, Google, l’université de Harvard et l’université de Stanford) ont constaté qu’une attaque sur GPT-2 – la version antérieure du modèle de langage – permettait de récupérer avec succès des séquences de texte. Privilégiez alors une discussion avec vos collègues ou votre partenaire sur vos choix professionnels.